檢測CSAM的兒童安全算法NeuralHash可以操作嗎?蘋果回應:其他版本

溫州市鹿城區璟協網絡技術工作室

2021-08-19 10:22:17

94

開(kāi)發(fā)人員通過(guò)反向(xiàng)編譯發(fā)現,蘋果檢測icloud照片中是否存在兒童虐待資料(CSAM)的NeuralHash算法存在漏洞,黑客可以使用。開(kāi)發(fā)者Asuhariet Yvgar表示,在隐藏代碼的iOS 14.3中對(duì)NeuralHash算法進(jìn)行了反向(xiàng)工程處理,并重新配置爲Python。

通過(guò)深入調查,他發(fā)現兩(liǎng)個不一緻的圖像有可能(néng)共享相同的哈希值。由于潛在的沖突可能(néng)會(huì)利用CSAM系統,安全研究人員警告這(zhè)種(zhǒng)可能(néng)性。

在對(duì)Motherboard的聲明中,蘋果表示Yvgar逆向(xiàng)工程的NeuralHash版本與將(jiāng)用于CSAM系統的最終實現不同。蘋果還(hái)公開(kāi)了該算法,以供安全研究人員驗證,但表示,有第二個專用服務器端算法,可以在超過(guò)阈值後(hòu)确認CSAM匹配和手動驗證。

但是蘋果公司向(xiàng)Motherboard發(fā)送電子郵件,稱用戶在GitHub上分析的版本不是iCloud照片CSAM測試中使用的最終版本,而是通用版本。蘋果公司表示,該算法也公開(kāi)了。

蘋果在一篇支持文檔中說:“NeuralHash算法[.]寫道(dào):“作爲簽名操作系統代碼的一部分,[并且]安全研究員可以确認其動作是否符合說明。”蘋果還(hái)表示,用戶通過(guò)30個匹配阈值後(hòu),在蘋果服務器上運行的第二個非公開(kāi)算法將(jiāng)确認結果。

- Headline: Guo yue:

- 瑞典遊戲巨頭MTG以3.6億美元收購

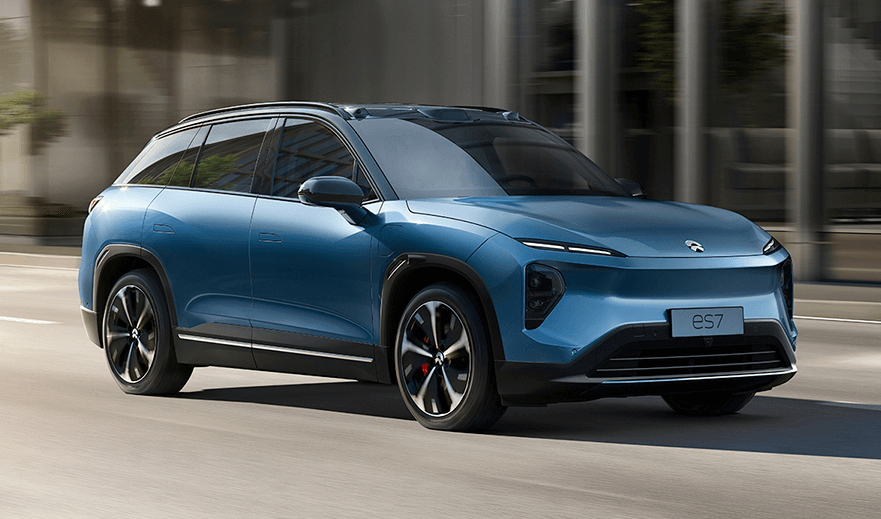

- 福星智能(néng)電動車組可以用手機篩選一下看

- 對(duì)“中國(guó)郵政儲蓄銀行罰款449萬人”

- 創新舉措取得良好(hǎo)效果 馬克西姆環境成(chéng)

- 中農協硒委員會(huì):推進(jìn)帶動富硒農業健康

- 2021年Q2 什麼(me)應用程序和遊戲正

- IDC:由于芯片短缺 OEM優先制造

- 京華網校怎麼(me)樣(yàng)?一篇文章了解京華曆史

- 作者的最新文章

- 在數字音樂軌道(dào)轉折點下 即時通訊音樂

- 共享辦公巨頭WeWork終于成(chéng)功登陸

- 小米汽車15.5億拿地落滬?知情人士

- 卡巴斯基發(fā)出警告:警惕打著(zhe)2022世

- 前三個季度淨利增速超60% 海爾智家

- 三星s20ultra1億像素:片名:

- 3080非公顯卡評測,3090不見了

- 在《東八區》的“黑色紅色”狂歡節之後(hòu)

- 蘋果ar app 蘋果正在開(kāi)發(fā)新版“

- Headline: YouTube取